Fill form to unlock content

Error - something went wrong!

Téléchargez le livre numérique gratuit.

Merci

Bulletin The Geospatial Edge : numéro 15 | T4 2025

Le bulletin The Geospatial Edge est publié par Esri Canada à l'intention des gestionnaires et des professionnels chargés de développer les capacités géospatiales de leur organisation. Dans ce numéro, Matt Lewin explique comment l'IA entraîne de nouvelles exigences en matière de gouvernance et présente des recommandations aux gestionnaires de systèmes d'information géographique (SIG) sur les moyens de faire face à ce changement.

En 2022, j’ai écrit un article intitulé « Précis de gouvernance SIG », qui décrivait un cadre simple de gouvernance des SIG et la manière de l’utiliser afin d’améliorer la surveillance des programmes SIG. (Vous pouvez également le lire sur LinkedIn.) L’idée maîtresse de cet article était que les programmes SIG les plus efficaces reposaient sur la mise en place diligente d’un système de règles, de pratiques et de processus orientant leurs efforts. Il a eu son utilité, et de nombreux autres ont fait évoluer ces concepts depuis lors.

Cela dit, les temps changent.

Au cours des quelques années qui ont suivi la publication de cet article, l’intelligence artificielle (IA) générative et d’autres technologies basées sur l’IA ont bouleversé le monde des SIG, en introduisant des solutions telles que les assistants intelligents et les agents autonomes. Ces progrès ont créé une toute nouvelle catégorie de défis en matière de gouvernance, issus de la tendance à la prise de décision par des machines et des préoccupations relatives à la confiance et à la fiabilité.

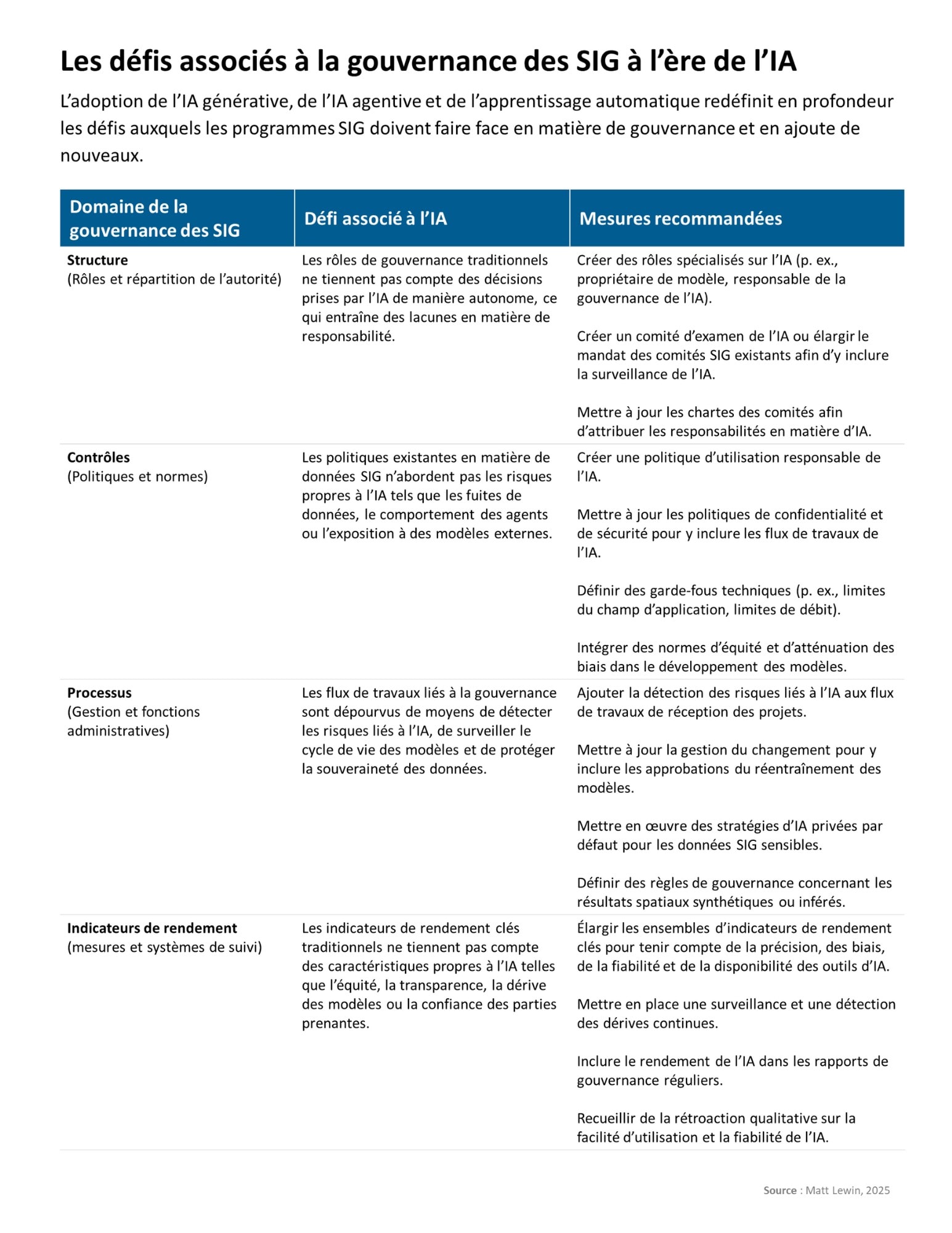

Le cadre simplifié de l’article initial « Précis de gouvernance SIG » (couvrant la structure, les contrôles, les processus et le rendement dans six domaines) reste une base solide. Toutefois, le contenu de ces composantes a changé : nous avons besoin d’intégrer de nouveaux rôles ou ensembles de responsabilités dans la structure afin de surveiller l’IA, de mettre en place des contrôles nouveaux ou révisés (politiques et normes) pour guider l’utilisation éthique de l’IA, de suivre des processus actualisés pour gérer le cycle de vie de l’IA (de l’approbation à l’audit) et même d’utiliser de nouveaux indicateurs de rendement (par exemple, la mesure de la précision ou des biais du modèle d’IA pour évaluer la réussite du programme).

Voici quelques-unes de mes observations sur la façon dont l’IA entraîne de nouvelles exigences en matière de gouvernance et de mes recommandations aux gestionnaires sur les moyens de faire face à ce changement.

Les défis associés à la gouvernance des SIG à l’ère de l’IA

Structure : nouvelles fonctions de surveillance de l’IA

L’IA introduit dans les programmes SIG des dynamiques d’imputabilité et de prise de décision que les structures de gouvernance traditionnelles n’ont pas été conçues pour gérer.

Par exemple, lorsqu’un système assisté par l’IA fournit une analyse spatiale ou génère une carte de manière autonome, qui est responsable en cas de problème? La gouvernance existante désigne généralement une personne (par exemple, le propriétaire des données ou de l’application) comme responsable de ces résultats, mais, avec l’IA, les algorithmes agissent de plus en plus souvent de manière partiellement autonome. Si les rôles ne sont pas mis à jour, on risque de se renvoyer davantage la balle. L’émergence de nouveaux rôles de surveillance apporte des solutions à cette situation.

Par exemple, les lignes directrices générales en matière de technologies de l’information prévoient désormais la création d’un comité d’examen de l’IA. Il s’agit d’un comité pluridisciplinaire qui examine et oriente l’utilisation de l’IA et réunit des parties prenantes des domaines juridique, éthique, de la science des données et des affaires. Ses tâches consistent notamment à surveiller les biais, à approuver les déploiements de l’IA à fort impact et à contrôler la conformité sur le plan de l’éthique. Cela s’applique sans nul doute au déploiement des solutions SIG, et un tel comité devrait idéalement posséder une certaine expertise en la matière. Une autre solution consiste à intégrer une expertise en matière d’IA dans les comités de gouvernance des SIG (lorsqu’ils existent). Cela permet de s’assurer que chaque fois que l’IA fait partie d’une décision, quelqu’un autour de la table la comprend et en assume les conséquences.

Un autre rôle qui semble émerger est celui de propriétaire ou d’intendant de modèle. Les lignes directrices d’IBM relatives à la gouvernance des données pour l’IA générative suggèrent de désigner un propriétaire de modèle qui soit responsable de la génération et du fonctionnement de chaque modèle d’IA pertinent. Cette personne veillerait à ce que le modèle soit développé et déployé conformément aux politiques de gouvernance. Par ailleurs, une personne expérimentée dans l’entraînement de modèles spatiaux devrait se voir confier la propriété des programmes hautement spécialisés que sont les modèles d’apprentissage automatique et les modèles vision-langage spatiaux, ainsi que la responsabilité de leur intégrité et de leur alignement sur les normes générales relatives à l’IA.

Étapes pour relever le défi :

Introduire des rôles propres à l’IA, comme :

- propriétaire de modèle – responsable du cycle de vie, du rendement et de l’utilisation éthique d’un modèle d’IA;

- responsable de la gouvernance de l’IA – surveille la stratégie d’IA, les risques et le respect des normes et politiques de l’organisation.

Créer un comité d’examen de l’IA ou élargir le mandat des comités existants pour y inclure la surveillance de l’IA. Un groupe pluridisciplinaire (leadership dans les domaines juridique, éthique, de la science des données et des SIG) devrait examiner les cas d’utilisation de l’IA à fort impact, approuver les déploiements et contrôler les résultats.

Mettre à jour les chartes des comités afin d’y inclure les responsabilités en matière d’IA. Par exemple, le sous-comité chargé des données SIG devrait surveiller la qualité et les biais des données d’entraînement de l’IA, tandis que le sous-comité de la technologie devrait examiner l’architecture et la sécurité des systèmes d’IA.

Contrôles : l’IA intégrée dans les politiques sur les données spatiales

Les contrôles conventionnels de la gouvernance des SIG, tels que les documents de politique et les directives d’utilisation, sont souvent dépourvus de mécanismes applicables aux comportements propres à l’IA et pourraient devoir être révisés à l’ère de cette technologie.

De nombreuses organisations ont des règles sur la manière dont leurs données internes peuvent être partagées ou publiées, mais il se peut qu’elles ne couvrent pas, par exemple, les scénarios dans lesquels un employé transmettrait des données géospatiales exclusives à un service d’IA générative (comme ChatGPT) afin d’obtenir une analyse. Une telle action pourrait exposer par inadvertance des données sensibles à un modèle externe. En l’absence de politiques claires, le personnel peut ne pas se rendre compte que cela est interdit.

Une tactique consisterait à mettre en œuvre une « politique d’utilisation responsable de l’IA » ou à mettre à jour les politiques existantes relatives aux données afin qu’elles couvrent explicitement l’IA et les données SIG. Il pourrait s’agir d’ajouter des règles concernant les types des données qui peuvent être utilisées pour entraîner l’IA ou être entrées dans des outils d’IA tiers, des exigences selon lesquelles seules des plateformes d’IA approuvées et sécurisées peuvent être utilisées pour certaines données, et des directives sur l’examen du caractère sensible du contenu généré par l’IA avant sa diffusion.

De même, les politiques de sécurité doivent couvrir les déploiements des SIG qui accèdent à des services externes de grands modèles de langage ou ont besoin que des agents aient un accès privilégié au système. Veiller à ce que les systèmes d’IA fassent l’objet de tests de sécurité et à ce que tout outil d’IA disposant d’un accès privilégié au système soit soumis à des contraintes (un agent ne devrait pas se voir accorder des droits d’administration supérieurs à ses besoins, par exemple). L’IA agentive peut enchaîner les actions de manière imprévisible, de sorte que l’application du principe du moindre privilège (ne donner à l’IA que l’accès minimum nécessaire) devient un impératif procédural.

Étapes pour relever le défi :

Créer une politique d’utilisation responsable de l’IA qui définira :

- l’utilisation acceptable de l’IA générative et agentive;

- les types de données autorisés pour l’entraînement de l’IA ou l’inférence par l’IA;

- les exigences en matière de contrôle humain des résultats générés par l’IA.

Mettre à jour les politiques de confidentialité et de sécurité pour y inclure :

- le masquage ou l’anonymisation des données avant leur traitement par l’IA;

- les restrictions relatives aux services infonuagiques ou aux API d’IA externes.

Définir des garde-fous techniques, tels que :

- des limites du champ d’application des agents d’IA (par exemple, l’interdiction de publier des données ou d’effectuer des opérations financières sans autorisation);

- des limites de débit, des niveaux d’autorisation et des protocoles de secours.

Intégrer des normes d’équité et d’atténuation des biais dans les flux de travaux de développement et de déploiement des modèles.

Processus : nécessité d’une surveillance dynamique

La gouvernance ne consiste pas à savoir seulement qui décide, mais aussi comment les décisions sont prises et appliquées au quotidien. L’IA introduit plusieurs nouvelles exigences relatives aux processus de gouvernance et exerce une pression sur les processus existants.

La plupart des programmes SIG sont assortis de procédures d’évaluation des nouveaux projets ou des nouvelles technologies – par exemple, un examen de l’architecture ou une liste de contrôle pour l’approbation des projets. Historiquement, il s’agissait de vérifier le budget, l’alignement sur la stratégie, la sécurité, etc. Aujourd’hui, il convient aussi de se poser la question suivante : avons-nous évalué les risques liés à l’IA? Les systèmes d’IA peuvent comporter des risques uniques, comme des biais algorithmiques, des comportements imprévisibles (« hallucinations ») ou des problèmes de conformité réglementaire (p. ex., l’utilisation d’un service d’IA infonuagique viole-t-elle les lois sur la protection de la vie privée ou la politique de souveraineté des données?). Si les processus de gouvernance n’intègrent pas explicitement ces considérations, des risques imprévus pourraient exister.

Il est particulièrement important de veiller au respect de la souveraineté des données. Les modèles d’IA formés sur des ensembles de données SIG souverains peuvent intégrer dans leurs paramètres des modèles spatiaux ou des détails d’infrastructure sensibles. Si ces modèles sont partagés ou commercialisés, il pourrait en résulter une exposition indirecte de données protégées, même si les données brutes ne sont pas explicitement partagées. Cette situation est particulièrement problématique pour ce qui concerne les données foncières sensibles et les actifs géospatiaux liés aux infrastructures critiques et à la défense.

En outre, l’IA générative est capable de produire de nouveaux contenus spatiaux (p. ex., des cartes synthétiques ou des couches d’utilisation des sols inférées) sur la base de données souveraines. Si ces résultats sont utilisés en dehors de leur territoire d’origine ou sans une gouvernance appropriée, ils peuvent saper le contrôle local sur la manière dont les connaissances spatiales sont représentées et utilisées.

Étapes pour relever le défi :

Les flux de travaux de réception des projets devraient inclure la détection des risques liés à l’IA. Cela consiste à se demander si la solution proposée utilise l’IA, quel type d’IA elle utilise le cas échéant et si elle nécessite un examen éthique ou de conformité.

La gestion du changement doit tenir compte des mises à jour des modèles d’IA. Si un modèle d’IA est réentraîné, la gouvernance doit définir qui approuve la nouvelle version et comment elle est testée.

Mettre en œuvre des stratégies d’IA « privées par défaut ». Il convient d’utiliser des modèles d’IA locaux ou sur place pour les données SIG sensibles ou de tirer parti d’architectures de génération augmentée par récupération (GAR) qui maintiennent les données à l’intérieur des limites où leur souveraineté est préservée.

Il faut établir des lignes directrices en matière de gouvernance pour le contenu spatial généré par l’IA. Il s’agit de définir des règles régissant la manière d’utiliser et de partager des résultats géospatiaux synthétiques ou inférés, en particulier lorsqu’ils sont dérivés d’ensembles de données souverains.

Rendement : indicateurs de rendement propres à l’IA

À mesure que l’IA est intégrée dans les programmes SIG, la gouvernance traditionnelle du rendement doit évoluer pour prendre en compte les nouvelles dimensions de la réussite, de la responsabilité et du risque.

Historiquement, le rendement des programmes SIG était mesuré à l’aide d’indicateurs comme la disponibilité du système, la qualité des données et la satisfaction des utilisateurs. Cependant, l’IA introduit des comportements complexes et dynamiques, comme la prise de décision autonome, la génération de résultats et la dérive des modèles, qui nécessitent une surveillance plus nuancée et continue.

L’un des principaux défis consiste à redéfinir la notion de « réussite ». Les résultats SIG propulsés par l’IA doivent être évalués non seulement du point de vue de l’exactitude technique, mais aussi du point de vue de l’équité, de la transparence et du respect de l’éthique. Par exemple, un modèle d’une grande précision globale peut néanmoins produire des résultats biaisés qui nuisent de manière disproportionnée à certaines communautés. La gouvernance doit intégrer des audits de l’équité, la détection des biais et des mesures de la confiance des parties prenantes afin de garantir des résultats équitables.

Les décisions fondées sur l’IA doivent également pouvoir être expliquées et retracées, en particulier lorsqu’elles sont prises dans des contextes d’aménagement, de services publics ou de réglementation. Les cadres de gouvernance devraient permettre de savoir à quelle fréquence les résultats de l’IA sont invalidés par des évaluateurs humains, si des explications sont disponibles et si les principes éthiques sont bien intégrés dans les flux de travaux.

D’un point de vue technique, le suivi du rendement devient également plus complexe. Les modèles d’IA peuvent se dégrader au fil du temps en raison de la dérive des données ou de l’évolution des conditions. La gouvernance des SIG doit mettre en œuvre des protocoles de validation continue et de réentraînement des modèles. Les tableaux de bord devraient rendre compte de l’exactitude et de la conformité du modèle, de la même manière que l’on suit aujourd’hui l’état d’un système.

Cela implique entre autres choses d’investir dans une infrastructure de surveillance, notamment des journaux d’audit et des tableaux de bord centralisés. Une telle infrastructure permet de connaître le comportement de l’IA.

Étapes pour relever le défi :

Élargir les ensembles d’indicateurs de rendement clés. Complétez vos indicateurs de rendement des SIG existants avec des indicateurs axés sur l’IA. Les indicateurs retenus pourraient viser l’exactitude, les biais, la confiance des utilisateurs et la disponibilité de l’IA.

Mettre en place une surveillance continue. Ne considérez pas l’évaluation de l’IA comme une opération ponctuelle. De nombreuses plateformes d’IA peuvent surveiller si les données d’entrée changent ou si les résultats commencent à s’écarter des modèles attendus. Abonnez-vous à des alertes qui mettent en lumière ces dérives.

Effectuer des rapports réguliers sur les résultats de l’IA. Intégrez le rendement de l’IA dans les rapports de gouvernance réguliers. Par exemple, dans les rapports trimestriels destinés à votre comité directeur SIG, incluez une section que l’on pourrait intituler « L’IA dans nos opérations : voici ce qu’elle a fait, voici son rendement, voici les problèmes éventuels et la manière dont nous les avons résolus ». Les membres de la direction restent ainsi conscients des contributions et des défis de l’IA, ce qui est important pour la responsabilisation.

Mettre en place des mesures qualitatives. En plus des données chiffrées, recueillez de la rétroaction qualitative. Mettez en place un canal ouvert permettant aux utilisateurs de signaler les problèmes ou les comportements étranges des outils d’IA. Assurez le suivi du nombre de suggestions d’amélioration liées à l’IA. Il peut s’agir d’un indicateur de rendement en soi (si trop de personnes déclarent que « l’IA n’est pas utile », il y a un problème à résoudre).

L’IA intégrée dans votre stratégie SIG

Je m’en voudrais de ne pas mentionner la stratégie. De nombreux plans stratégiques SIG ne tenaient pas compte de l’IA à l’origine ou la considéraient comme un sujet d’innovation lointain. Maintenant que l’IA générative et l’IA agentive se généralisent (les logiciels SIG intègrent des capacités d’IA et les utilisateurs les attendent), l’absence d’une orientation claire en matière d’IA constitue une lacune dans la gouvernance.

Des organisations peuvent finir par mener des expériences ponctuelles sur l’IA (certains services allant de l’avant, d’autres restant en retrait) qui ne s’alignent pas sur leurs objectifs à long terme. La gouvernance au niveau stratégique doit garantir l’existence d’un plan d’action cohérent en matière d’IA : soit dans le cadre de la stratégie SIG, soit dans le cadre d’une stratégie d’IA autonome qui s’articule avec elle.

Cette stratégie devrait répondre aux questions suivantes : Où appliquerons-nous l’IA dans notre programme géospatial? Quels sont les objectifs de ces cas d’utilisation de l’IA? Quelle est notre propension à prendre des risques en matière d’IA? Quels sont les investissements nécessaires en matière de compétences et de technologies?

Par exemple, si la stratégie SIG d’une ville comprenait l’amélioration de la participation citoyenne, le plan pourrait maintenant inclure le déploiement d’un assistant d’IA générative pour répondre aux demandes de renseignements spatiaux de la population. Quel que soit le mode de gestion adopté, les responsables doivent agir proactivement pour mettre à jour leurs stratégies SIG existantes et s’assurer que les efforts en matière d’IA sont déployés de manière productive.

L’introduction de l’IA générative et agentive dans les programmes géospatiaux s’accompagne de formidables possibilités (analyse plus rapide, services innovants, automatisation des tâches fastidieuses), mais aussi d’importants défis en matière de gouvernance concernant la responsabilité, la gestion des données et les risques.

Le changement d’état d’esprit le plus important est peut-être de reconnaître que la gouvernance elle-même doit être agile et innovante. Tout comme la technologie SIG innove, les pratiques de gouvernance ne peuvent pas rester statiques. Les responsables doivent considérer le cadre de gouvernance comme un outil vivant et l’adapter au fur et à mesure que les cas d’utilisation de l’IA se développent. Il peut s’agir de tester un « addenda sur la gouvernance de l’IA » dans la charte de gouvernance de votre programme SIG, puis de le peaufiner. Il vaut mieux commencer par établir des lignes directrices et des comités sur l’IA (même s’ils ne sont pas parfaits) plutôt que de laisser l’IA complètement sans gouvernance dans un environnement qui évolue rapidement. Avec les bons ajustements, vous serez en meilleure position pour naviguer en toute confiance dans l’ère de l’IA et atteindre les objectifs de votre programme SIG dans un paysage technologique en pleine mutation.

Parlons-en ensemble

Exploitez-vous le potentiel de l’IA et des agents d’IA pour votre entreprise? Êtes-vous préoccupé par la gouvernance de votre programme SIG dans un monde dominé l’IA? Envoyez-moi un courriel ou connectez-vous avec moi sur LinkedIn. J’aimerais connaître votre avis!

Cordialement,

Matt

The-Geospatial-Edge est un bulletin d’information périodique sur la stratégie géospatiale et l’intelligence de localisation édité par Matt-Lewin, directeur des services-conseils stratégiques d’Esri-Canada. Si ce courriel vous a été transmis et que vous souhaitez recevoir le bulletin d’information The-Geospatial-Edge et les messages connexes d’Esri-Canada, visitez notre centre de préférences en matière de communications et cochez la case «-Stratégie SIG-» parmi les champs d’intérêt.-

Ce billet a été écrit en anglais par Matthew Lewin et peut être consulté ici.